信息科學技術學院2篇成果被國際先進人工智能協會錄用

暨南大學融媒體中心訊 AAAI全稱為國際先進人工智能協會(Association for the Advancement of Artificial Intelligence),是人工智能和機器學習領域的頂級會議,據最新中國計算機學會(CCF)推薦國際學術會議和期刊目錄,AAAI為人工智能領域的A類會議。AAAI 2025會議共有12,957篇投稿,接收率僅為 23.4%。我校信息科學技術學院2篇成果被AAAI錄用。

入選論文介紹

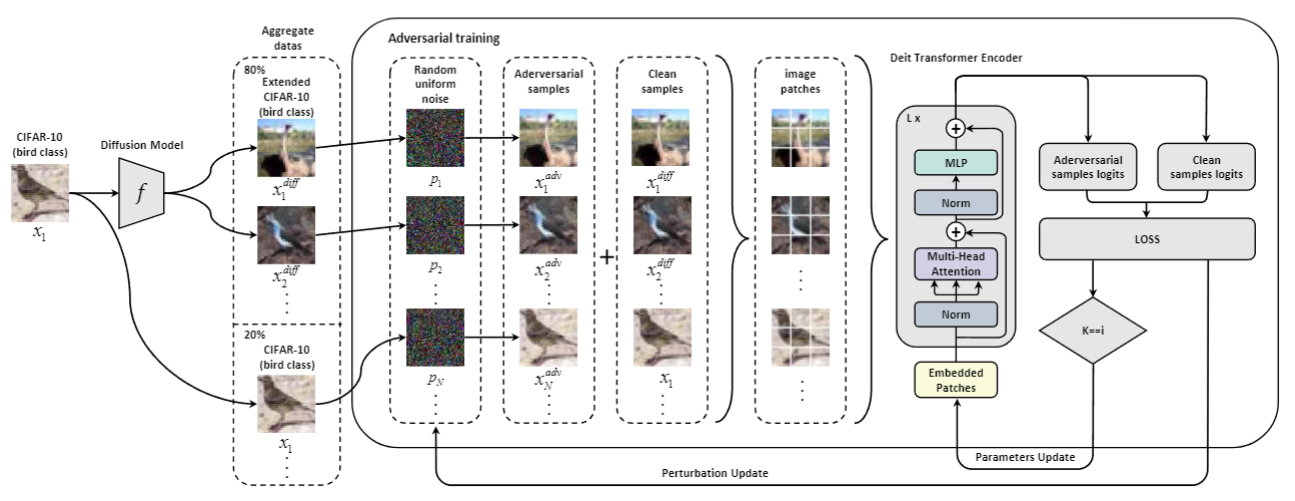

論文題目:小規模數據集上視覺Transformer在魯棒性上優于WideResNets

作者名字:鄔鈞陶(暨南大學)、宋子玉(暨南大學)、張曉鈺(暨南大學)、謝淑君(暨南大學)、林龍新(暨南大學)、王苛(暨南大學)

通訊作者:王苛

摘要:在長時間內,視覺Transformers(ViTs)一直被認為不適合在小規模數據集上獲得強大的表現,而WideResNet模型則在這一領域占據主導地位。盡管WideResNet模型在CIFAR-10和CIFAR-100等數據集上持續設定了最先進的(SOTA)魯棒性準確率,但本文挑戰了只有WideResNet能夠在這一背景下表現優異的普遍觀點。我們提出了一個關鍵問題:ViTs是否能夠超越WideResNet模型的魯棒性準確率?我們的結果給出了一個肯定答案。通過結合擴散模型生成的數據進行對抗訓練,我們證明了ViTs確實可以在魯棒性準確率方面超越WideResNet。具體而言,在無窮范數威脅模型下,epsilon = 8/255時,我們的方法在CIFAR-10上達到了74.97%的魯棒準確率,在CIFAR-100上達到了44.07%的魯棒準確率,相較于之前的SOTA模型,分別提高了+3.9%和+1.4%。值得注意的是,我們的ViT-B/2模型,參數量是WRN-70-16的三分之一,且超越了此前表現最好的WRN-70-16。我們的成就開辟了一條新道路,未來采用ViTs或其他新型高效架構的模型,可能最終取代長期主導的WRN模型。

框架流程圖

論文題目:情景演算中計算完備且正確抽象的句法方法

作者名字:方良達(暨南大學)、王曉曼(暨南大學)、陳長(暨南大學)、羅凱倫(東莞理工大學)、崔振河(湖南科技大學)、官全龍(暨南大學)

通訊作者:官全龍

摘要:抽象是人工智能領域中一個重要且有用的概念。據我們所知,目前還沒有一種句法方法可以從給定的低階基本動作理論和細化映射中計算出完備且正確的抽象動作理論。本文旨在解決這個問題。為此,本文首先提出一種情景演算的變體,即線性整數情景演算,它用作高階基本動作理論的描述框架。然后,本文將Banihashemi、De Giacomo和 Lesperance三人提出的抽象框架遷移至一個從線性整數情景演算到擴展情景演算的框架。此外,本文確定一類 Golog 程序,即受限動作,用于限制低階 Golog 程序,并對細化映射施加了一定的限制。最后,本文設計一種句法操作,用于從低階基本動作理論和受限細化映射中,計算出完備且正確的抽象動作理論。

責編:蘇倩怡